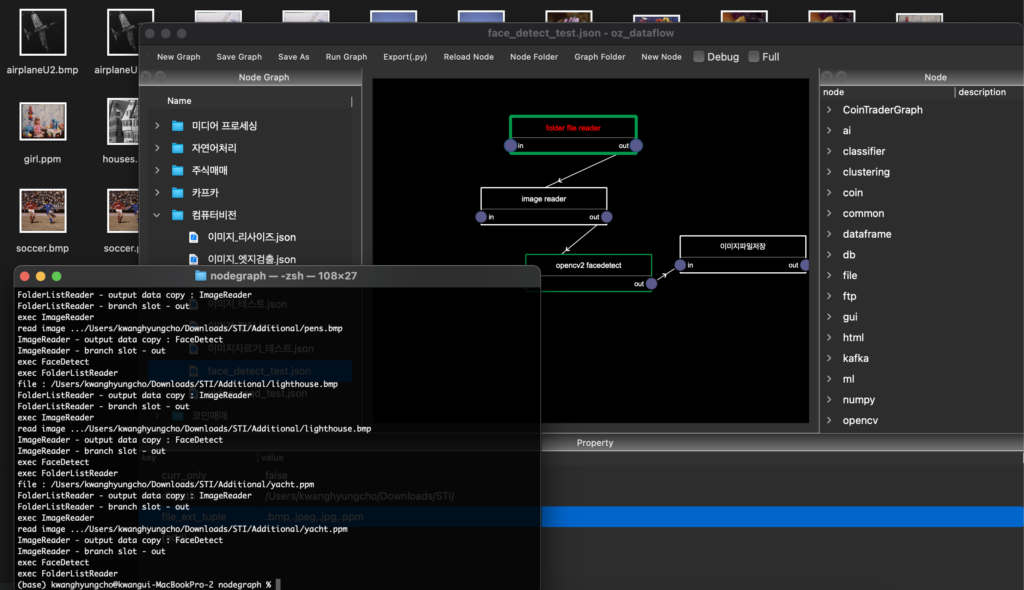

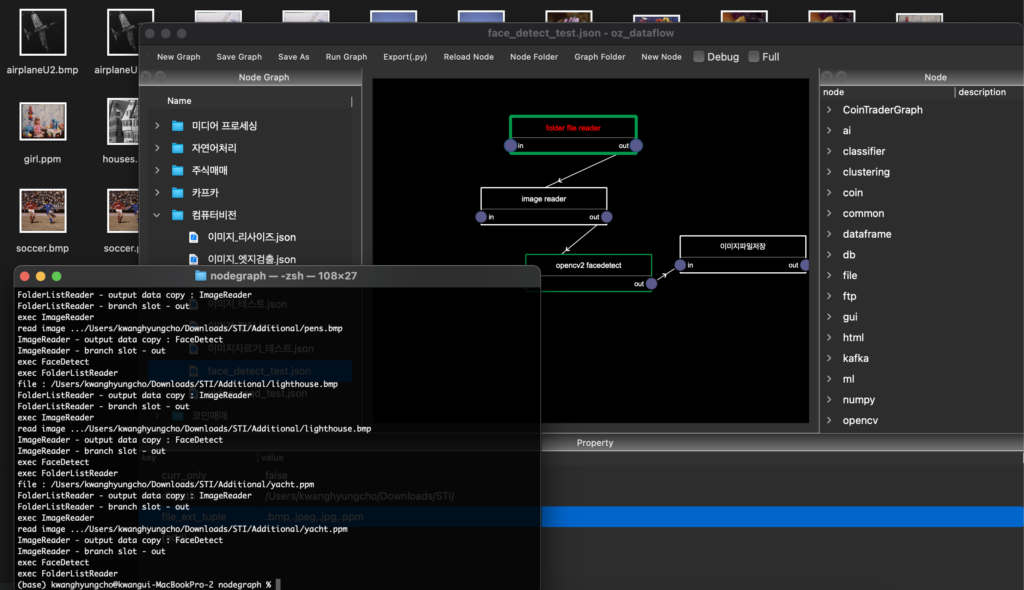

고속, 대량의 데이터 및 연속된 데이터 수집/처리용 프로그램, 편리하고 사용자 친화적 사용자 경험의 데이터 처리 및 가공 종합 솔루션

고속, 대량의 데이터 및 연속된 데이터 수집/처리용 프로그램, 편리하고 사용자 친화적 사용자 경험의 데이터 처리 및 가공 종합 솔루션

추천 시스템은 현대 전자상거래, 콘텐츠 플랫폼 및 소셜 미디어에서 중요한 역할을 하는 기술로, 사용자에게 개인화된 경험을 제공하는 데 중점을 둡니다. 추천 시스템의 성공은 주로 사용자 행동 데이터와 고유한 특성을 포함한 충분한 양의 학습 데이터에 의존합니다. 본 포스트에서는 아마존 제품 리뷰 데이터셋(Amazon Product Review Dataset)을 자세히 살펴보며, 이 데이터셋이 추천 시스템 개발에 어떻게 기여하는지 설명하겠습니다.

추천 시스템은 사용자 맞춤형 콘텐츠, 상품 또는 서비스를 제안함으로써 사용자 경험을 향상시키고, 고객의 구매를 유도하는 데 필수적입니다. 특히 아마존과 같은 대형 전자상거래 플랫폼에서는 수많은 제품 중에서 사용자에게 적합한 상품을 추천하여 구매 결정을 쉽게 합니다. 이러한 추천 시스템은 다양한 알고리즘, 머신러닝, 딥러닝 기술을 활용하여 구현됩니다.

추천 시스템을 효과적으로 개발하기 위해서는 많은 양의 사용자 행동 데이터가 필요합니다. 해당 데이터셋은 사용자의 취향, 관심사, 구매 이력, 행동 패턴 등을 분석하여 추천 품목을 개인화하는 데 사용됩니다. 사용자가 특정 제품에 남긴 리뷰와 평점은 이러한 데이터셋의 중요한 구성 요소로 작용하며, 모델 훈련 및 평가에 필수적인 자원입니다.

아마존 제품 리뷰 데이터셋은 사용자들이 특정 제품에 대해 작성한 리뷰와 함께 해당 제품에 대한 평점을 포함하는 방대한 데이터셋입니다. 이 데이터셋은 특정 제품을 구매한 소비자들의 진솔한 피드백을 통해, 제품의 특징 및 사용자의 선호도를 분석할 수 있는 기회를 제공합니다. 아마존에서는 이 데이터셋을 기반으로 다양한 연구와 개발이 이루어지고 있으며, 추천 시스템의 품질을 향상시키는 데 기여하고 있습니다.

Amazon Product Review Dataset은 다음과 같은 주요 요소로 구성되어 있습니다:

아마존 제품 리뷰 데이터셋은 다음과 같은 다양한 용도로 활용될 수 있습니다:

Amazon Product Review Dataset은 다양한 형식으로 공개되어 있으며, 연구자들과 개발자들이 자유롭게 사용할 수 있습니다. 데이터셋은 다음의 경로에서 다운로드할 수 있습니다:

추천 시스템을 구현하기 위해 기본적으로 다음과 같은 단계가 필요합니다:

추천 시스템의 발전은 소비자 행동 데이터의 수집과 분석에 큰 영향을 받고 있으며, Amazon Product Review Dataset은 이러한 연구의 핵심 자원으로 자리 잡고 있습니다. 이 데이터셋은 사용자가 자신의 경험을 공유하고, 필요한 정보를 기반으로 한 맞춤형 추천을 제공하는 데 필수적인 요소로 작용합니다. 따라서 데이터의 구조와 특성을 이해하고 사용하는 것이 매우 중요합니다.

추천 시스템 관련 연구에 있어 Amazon Product Review Dataset은 풍부한 데이터를 제공할 뿐만 아니라, 새로운 아이디어와 기술을 찾는 데 영감을 줄 수 있습니다. 앞으로의 연구에서도 이러한 데이터셋이 더욱 많은 활용을 통해 사용자 경험을 향상시키는 데 기여하기를 기대합니다.

딥러닝 및 머신러닝 모델을 효과적으로 학습시키기 위해서는 적절한 데이터셋이 필수적입니다. 데이터셋의 품질과 양이 모델의 성능에 직접적인 영향을 미치기 때문에, 자신만의 데이터셋을 구축하는 것은 데이터 사이언스의 중요한 단계입니다. 이 글에서는 데이터셋 구축에 관한 여러 가지 방법, 데이터 수집 기술 및 공개된 데이터를 얻을 수 있는 웹사이트들을 소개합니다.

머신러닝과 딥러닝의 기본 원리는 데이터에 있습니다. 특정 문제를 해결하기 위해서는 다양한 예제를 포함하는 데이터를 수집하여 모델을 학습시켜야 합니다. 좋은 데이터셋은 다음과 같은 특징을 가지고 있습니다:

데이터를 수집하는 방법은 다양합니다. 주로 사용되는 방법은 크롤링, API 활용, 공개 데이터셋 사용 등입니다. 각 방법에 대해 자세히 살펴보겠습니다.

웹 크롤링은 웹사이트에서 자동으로 데이터를 수집하는 방법입니다. 이를 통해 대량의 데이터를 손쉽게 얻을 수 있으며, 특정 주제에 대한 정보를 빠르게 수집할 수 있습니다. 웹 크롤링을 시작하기 위해서는 다음과 같은 과정을 따릅니다:

import requests

from bs4 import BeautifulSoup

# 크롤링할 웹페이지 URL

url = 'https://example.com'

# 요청 보내기

response = requests.get(url)

# BeautifulSoup을 사용하여 HTML 파싱

soup = BeautifulSoup(response.text, 'html.parser')

# 데이터 추출

data = []

for item in soup.find_all('h2'): # 예: 모든 h2 태그 추출

data.append(item.text)

print(data)

응용 프로그램 인터페이스(API)는 서버와 클라이언트 간 데이터를 교환하기 위한 방법입니다. 많은 웹 서비스에서는 API를 제공하여 사용자가 데이터를 요청할 수 있게 합니다. API를 사용하면 필요한 데이터만 선택적으로 수집할 수 있어 매우 유용합니다.

API 활용 과정은 다음과 같습니다:

import requests

# API 요청

url = 'https://api.example.com/data'

response = requests.get(url, headers={'Authorization': 'Bearer YOUR_API_KEY'})

# 데이터 처리

data = response.json()

print(data)

오픈 데이터셋은 다양한 분야에 걸쳐 무료로 사용할 수 있는 데이터셋입니다. 이러한 데이터셋은 이미 정제 및 전처리 과정이 완료되어 있어 머신러닝 모델 학습에 바로 사용할 수 있습니다.

몇 가지 유용한 공개 데이터셋 리소스를 소개합니다:

더 나은 데이터셋을 구축하기 위해 다음과 같은 사항에 유의해야 합니다:

자신만의 데이터셋을 구축하는 것은 머신러닝 및 딥러닝 프로젝트의 성공에 필수적인 요소입니다. 다양한 방법과 기술을 활용하여 데이터를 수집하고, 이를 통해 더욱 정확한 예측 모델을 만들 수 있습니다. 이 글에서 설명한 크롤링, API 활용, 공개 데이터셋 사용 방법을 통해 여러분의 프로젝트에 필요한 데이터를 효과적으로 구축해 보시기 바랍니다.

컴퓨터 비전(computer vision) 분야는 다양한 알고리즘과 모델을 통해 이미지와 비디오 데이터를 이해하고 분석하는 기술을 포함합니다. 이 분야의 발전은 머신러닝과 특히 딥러닝의 발전에 크게 의존하고 있으며, 이러한 기술이 효과적으로 작동하기 위해서는 고품질의 데이터가 필수적입니다. 그 중에서도 ImageNet은 이미지 분류 및 객체 인식 분야에서 가장 널리 사용되고 있는 대규모 데이터셋 중 하나입니다. 이 글에서는 ImageNet의 역사, 구조, 발전 기여도 및 데이터를 활용할 수 있는 방법에 대해 자세히 설명하겠습니다.

ImageNet 프로젝트는 2009년 Stanford 대학의 Fei-Fei Li 교수가 주도하여 시작되었습니다. 초기 목표는 이미지 인식의 발전을 위해 대규모로 라벨링된 데이터셋을 만드는 것이었습니다. ImageNet은 14,197,122장의 이미지를 포함하고 있으며, 20,000개 이상의 개체 카테고리로 분류됩니다. 이 데이터셋은 매년 열리는 ImageNet Large Scale Visual Recognition Challenge (ILSVRC)에서 사용되며, 이는 컴퓨터 비전 분야에서 중요한 연구 대회로 자리잡았습니다.

ImageNet의 데이터셋은 주로 세 가지 부분으로 나눌 수 있습니다:

이 데이터셋의 클래스를 구성하는 방법은 WordNet이라는 언어 데이터베이스를 사용하여 각 개체의 계층 구조를 정의함으로써 이루어졌습니다. 각 개체 카테고리는 synset으로 알려진 의미 단위에 맞춰 설정되었습니다. 이는 모델이 더 나은 일반화 성능을 얻을 수 있도록 돕는 중요한 요소입니다.

ImageNet 데이터셋의 출현은 딥러닝 분야에서 혁신적인 발전을 촉진했습니다. 2012년 ILSVRC 대회에서 AlexNet이라는 모델이 등장하여 이미지 분류에서 15.3%의 오류율로 최종 우승을 차지했습니다. 이는 기존의 방법에 비해 현저히 낮은 수치로, 딥러닝 모델이 이미지 인식에 있어 획기적인 전환점이 되었음을 보여주었습니다. AlexNet은 더 깊은 신경망 구조와 더 넓은 데이터 세트의 활용으로 인해 놀라운 성능을 보였습니다.

그 이후로 VGG, GoogLeNet, ResNet 등의 다양한 모델들이 등장하여 ImageNet 데이터셋에서 성능을 지속적으로 개선해 나갔습니다. 이러한 발전은 ImageNet의 규모와 다양성 덕분에 가능했으며, 연구자들은 이를 통해 새로운 알고리즘을 개발하고 최적화하는 데 중요한 기초 자료로 활용할 수 있었습니다.

ImageNet 데이터셋은 학습, 평가 및 테스트의 다양한 목적으로 활용될 수 있습니다. 주요 활용 방법은 다음과 같습니다:

ImageNet 데이터셋은 공식 웹사이트에서 다운로드할 수 있습니다. 그러나 사용자는 등록 후 데이터셋에 접근할 수 있으며, 신청서를 제출하여 승인을 받아야 합니다. 다음은 데이터셋 다운로드 절차입니다:

ImageNet 데이터셋은 컴퓨터 비전 분야에서 가장 중요한 데이터셋 중 하나로, 이미지 분류 및 객체 인식 분야에서의 연구와 개발에 큰 기여를 하고 있습니다. 이 데이터셋은 딥러닝 모델의 발전을 이끌며, 새로운 알고리즘의 성능 평가 및 최적화의 기준으로 자리잡았습니다. 향후에도 ImageNet은 컴퓨터 비전 분야의 연구자들에게 지속적으로 활용될 것이며, 그 중요성은 더욱 커질 것으로 예상됩니다. 연구자와 개발자는 이 데이터를 효과적으로 활용하여 컴퓨터 비전 기술의 경계를 넓혀갈 수 있습니다.

딥러닝과 머신러닝의 발전에 힘입어 데이터의 중요성이 날로 커지고 있습니다. 정확하고 충분한 양의 데이터가 없다면, 머신러닝 모델의 성능은 저하될 수밖에 없습니다. 따라서 본 글에서는 자신만의 데이터셋을 구축하는 방법과 데이터 어노테이션 및 라벨링 툴에 대해 자세히 살펴보겠습니다.

데이터셋은 머신러닝 모델을 학습시키는 기본적인 요소로, 구축하는 방식과 품질에 따라 모델의 성능이 결정됩니다. 데이터셋을 구축하는 주된 목적은 다음과 같습니다:

자신만의 데이터셋을 구축하는 방법은 다음과 같습니다:

데이터 수집은 데이터셋 구축의 첫 단계입니다. 데이터 수집 방법은 다양하며, 다음과 같은 방법을 사용할 수 있습니다:

BeautifulSoup 및 Scrapy 라이브러리를 사용하여 데이터를 수집할 수 있습니다.데이터 수집 후, 데이터 클리닝 과정이 필수적입니다. 불필요한 데이터나 오류 데이터, 중복 데이터를 제거하여 깨끗한 데이터셋을 유지해야 합니다. 클리닝 과정에서는 다음을 고려해야 합니다:

모델 학습을 위해서는 데이터에 레이블을 부여해야 합니다. 레이블링 작업은 시간이 많이 소요될 수 있으며, 품질을 보장하기 위해서는 적절한 툴과 방법이 필요합니다.

데이터 라벨링을 위한 다양한 툴이 존재하며, 각 툴은 특정한 목적에 맞춰 설계되었습니다. 아래는 추천하는 라벨링 툴입니다:

Labelbox는 이미지 및 비디오 데이터 어노테이션을 위한 클라우드 기반의 솔루션입니다. 사용자 친화적인 인터페이스를 제공하며, 자동화된 도구를 통해 라벨링 작업을 효율적으로 수행할 수 있습니다.

Prodigy는 데이터 라벨링 및 어노테이션을 위한 연속적 학습 플랫폼입니다. 사용자가 필요에 따라 데이터를 수집하고, 라벨을 지정할 수 있도록 유연한 환경을 제공합니다.

VGG Image Annotator는 오픈 소스 라벨링 툴로, 이미지 데이터셋의 어노테이션 작업을 간편하게 수행할 수 있습니다. 웹 브라우저에서 직접 사용할 수 있으며, 다양한 형태의 라벨링을 지원합니다.

RectLabel은 MacOS에서 사용할 수 있는 데이터 어노테이션 툴입니다. 손쉬운 인터페이스와 다양한 기능을 제공하여 이미지 및 비디오에 대해 직관적으로 라벨을 부여할 수 있습니다.

LabelImg는 오픈 소스이며 이미지 라벨링을 위한 툴입니다. Python과 Qt를 기반으로 하며, YOLO 형식 및 PASCAL VOC 형식으로 데이터를 라벨링할 수 있습니다.

퍼블릭 영역에서 사용할 수 있는 여러 데이터셋도 존재합니다. 이들 데이터셋은 다양한 분야에서 연구와 교육을 위해 활용되며, 필요한 데이터를 효과적으로 수집할 수 있는 좋은 자원이 됩니다.

자신만의 데이터셋을 구축하는 과정은 시간이 많이 들고 어려운 과정일 수 있습니다. 하지만 올바른 방법론을 통해 단계별로 진행하면, 훨씬 더 나은 결과를 얻을 수 있습니다. 데이터 수집, 클리닝, 라벨링을 위한 적절한 툴을 활용하면 작업 효율성을 높일 수 있습니다.

마지막으로, 머신러닝과 딥러닝의 성공적인 프로젝트를 위해서는 데이터셋이 가장 중요하다는 점을 잊지 말아야 합니다. 정확하고 유의미한 데이터를 통해 좋은 모델을 구축하시기 바랍니다.